Los robots que hablan basura ponen nerviosos a los oponentes humanos

Hablar basura ha sido una táctica utilizada durante mucho tiempo para poner nerviosos a los oponentes del juego, y ahora un nuevo estudio muestra que las palabras desalentadoras pueden afectar el juego, incluso cuando provienen de un robot.

La charla basura en el estudio fue decididamente suave, con expresiones como "Tengo que decir que eres un jugador terrible" y "A lo largo del juego, tu juego se ha vuelto confuso". Aún así, las personas que jugaron un juego en particular con el robot, un robot humanoide disponible comercialmente conocido como Pepper, se desempeñaron peor cuando el robot los desanimó y mejor cuando el robot los alentó.

El autor principal, Aaron M. Roth, dijo que algunos de los 40 participantes del estudio eran técnicamente sofisticados y entendían completamente que una máquina era la fuente de su malestar.

"Un participante dijo: 'No me gusta lo que dice el robot, pero esa es la forma en que fue programado, así que no puedo culparlo'", dijo Roth, quien dirigió el estudio mientras era estudiante de maestría en Carnegie. Instituto de Robótica de la Universidad de Mellon (CMU).

Pero los investigadores encontraron que, en general, el desempeño humano fluctuaba independientemente del conocimiento técnico de los participantes.

El estudio, presentado el mes pasado en la IEEE International Conference on Robot & Human Interactive Communication (RO-MAN) en Nueva Delhi, India, es una desviación de los estudios típicos de interacción humano-robot, que tienden a centrarse en cómo los humanos y los robots pueden mejorar trabajar juntos.

“Este es uno de los primeros estudios de interacción humano-robot en un entorno en el que no cooperan”, dijo el coautor, el Dr. Fei Fang, profesor asistente en el Instituto de Investigación de Software.

El estudio tiene implicaciones significativas para un mundo donde se espera que la cantidad de robots y dispositivos de Internet de las cosas (IoT) con capacidades de inteligencia artificial crezca exponencialmente.

“Podemos esperar que los asistentes a domicilio cooperen”, dijo, “pero en situaciones como las compras en línea, es posible que no tengan los mismos objetivos que nosotros”.

El estudio fue una consecuencia de un proyecto de estudiante, un curso que imparte Fang. Los estudiantes querían explorar los usos de la teoría de juegos y la racionalidad limitada en el contexto de los robots, por lo que diseñaron un estudio en el que los humanos competirían contra un robot en un juego llamado "Guardias y tesoros". Un juego de Stackelberg, los investigadores lo utilizan para estudiar la racionalidad; Fang lo emplea en su investigación de ciberseguridad para estudiar la interacción defensor-atacante.

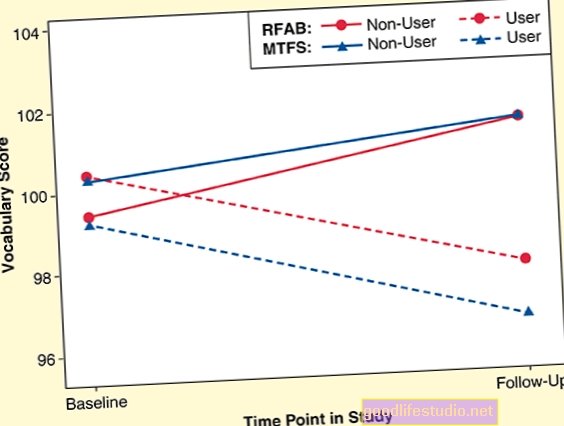

Para el estudio, cada participante jugó 35 veces con el robot, mientras disfrutaba de las palabras de aliento del robot o se ponía nervioso con comentarios desdeñosos. Aunque la racionalidad de los jugadores humanos mejoró a medida que aumentaba el número de juegos jugados, los que fueron criticados por el robot no puntuaron tan bien como los que fueron elogiados.

Es bien sabido que el desempeño de una persona se ve afectado por lo que otras personas dicen, pero el estudio muestra que los humanos también responden a lo que dicen las máquinas, dijo el Dr. Afsaneh Doryab, científico de sistemas del Instituto de Interacción Humano-Computadora (HCII) de CMU durante el estudio y ahora es profesor asistente en Sistemas de Ingeniería y Medio Ambiente en la Universidad de Virginia.

La capacidad de esta máquina para generar respuestas podría tener implicaciones para el aprendizaje automatizado, el tratamiento de salud mental e incluso el uso de robots como compañeros, dijo.

El trabajo futuro podría centrarse en la expresión no verbal entre robots y humanos, dijo Roth, ahora un Ph.D. estudiante de la Universidad de Maryland. Fang sugiere que se necesita aprender más sobre cómo los diferentes tipos de máquinas, por ejemplo, un robot humanoide en comparación con una caja de computadora, pueden evocar diferentes respuestas en los humanos.

Fuente: Universidad Carnegie Mellon