Documentos secretos: Facebook parece poner funciones, obtener ganancias por encima de la seguridad de los usuarios

Facebook, el gigante de 13 años con 1,23 mil millones de usuarios activos, genera más de $ 8 mil millones por trimestre en ingresos, de los cuales $ 3 mil millones son ingresos netos (por ejemplo, ganancias).

Pero con tantos usuarios, Facebook parece haber relegado la seguridad del usuario a una preocupación secundaria. Hasta principios de este año, Facebook empleaba solo a 4.500 personas para revisar el contenido. Lo que suena a mucha gente hasta que se da cuenta de que esos 1,23 mil millones de usuarios activos están compartiendo miles de millones de piezas de contenido todos los días, con millones de quejas de usuarios sobre el contenido de Facebook presentadas todos los días.

¿Facebook tiene un problema grave de seguridad del usuario en sus manos? Un recién publicado guardián La revisión de documentos internos secretos sugiere que su problema está fuera de control.

Facebook reconoció que tiene algún tipo de problema cuando a principios de este año acordó casi duplicar su personal de revisión, a 7.500, en medio de acusaciones de que la compañía simplemente no hace (¿o tal vez le importa?) Lo suficiente cuando se trafica contenido potencialmente dañino a través de su plataforma. . No duplica su personal de moderación si todo está bien.

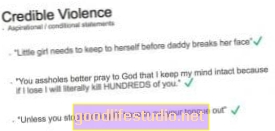

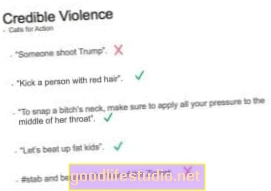

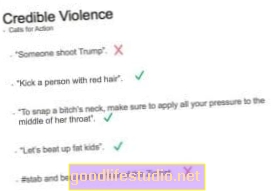

Ahora, The (Reino Unido) Guardian ha publicado detalles asombrosos de las pautas de moderación de contenido de Facebook, seleccionados de más de 100 manuales y documentación de capacitación internos secretos. Es un poco perturbador todo este material importante que no se encuentra en un solo manual que se les da a los moderadores de Facebook cuando son contratados.En cambio, parece ser un enfoque de política fragmentado, lo que da como resultado lo que parece ser información contradictoria, moderación desigual y muy poca confiabilidad en cómo funcionan realmente sus políticas moderadoras en el mundo real.

"Facebook no puede mantener el control de su contenido", dijo una fuente. "Ha crecido demasiado, demasiado rápido".

Se dice que muchos moderadores están preocupados por la inconsistencia y la naturaleza peculiar de algunas de las políticas. Los de contenido sexual, por ejemplo, se dice que son los más complejos y confusos.

Como un pequeño ejemplo de cuánto contenido modera Facebook, los artículos señalan: "Un documento dice que Facebook revisa más de 6,5 millones de informes a la semana relacionados con cuentas potencialmente falsas, conocidas como FNRP (persona falsa, no real)". Y eso es solo para cuentas falsas. Imagínese cuántos millones más de informes son para contenido real.

Características antes de pensar

Antes de pensar en cómo las personas podrían usar (y abusar) de una nueva función, Facebook parece favorecer la implementación de cosas y descubrir cómo moderarlas como una ocurrencia tardía. Mire Facebook Live, un servicio de transmisión de video que permite a las personas grabar en video cualquier cosa que esté sucediendo en su vida en el momento. ¿Para qué pensaban que la gente eventualmente lo usaría?

Esto muestra una falta constante de pensar en los problemas y abordarlos de manera proactiva antes de que surjan. O errar por el lado de, "Oye, sigamos con esto y veamos qué tipo de protesta se genera antes de hacer algo al respecto". (Todo en nombre de la "libertad de expresión", por supuesto, ignorando el hecho de que Facebook es una plataforma global) 1.

¿Dónde volví a poner esa pauta de moderación?

¿Y quizás ponerlos todos en un solo manual? ¿Entonces los moderadores saben dónde buscar y que todas las pautas sean coherentes?

Los videos de autolesiones están perfectamente bien en el mundo de Facebook, porque la persona está "en peligro". También lo es la crueldad hacia los animales (¿tal vez porque el animal está en peligro?). La "pornografía de venganza" también está bien, si el moderador no puede confirmar la falta de consentimiento de ambas partes (lo cual, imagino, podría ser bastante difícil de hacer de manera oportuna).

"Algunas fotos de abuso físico no sexual e intimidación de niños no tienen que ser borradas o" procesadas "a menos que haya un elemento sádico o de celebración". Mientras mantenga el sadismo y las celebraciones fuera de sus imágenes y videos violentos, aparentemente Facebook los permitirá.

Según los documentos, “Los videos de muertes violentas son inquietantes pero pueden ayudar a crear conciencia. Para los videos, creemos que los menores necesitan protección y los adultos necesitan una opción. Marcamos como 'inquietantes' videos de muertes violentas de humanos ". No está claro dónde el contenido suicida, como videos en vivo o amenazas, se incluye en las políticas de moderación de Facebook, pero parece estar permitido.

Facebook debe priorizar la seguridad del usuario

Algunos han pedido que Facebook esté más regulado, ya que es el guardián de todo este contenido (al igual que una emisora de televisión es el guardián del contenido en su red):

Un informe de los parlamentarios británicos publicado el 1 de mayo decía que “las empresas de redes sociales más grandes y ricas están vergonzosamente lejos de tomar medidas suficientes para abordar el contenido ilegal o peligroso, implementar estándares comunitarios adecuados o mantener seguros a sus usuarios”.

Errar por el lado de la "libertad de expresión" puede parecer una buena idea, especialmente para una empresa estadounidense. Pero las redes sociales son principalmente comunidades en línea, no se parecen mucho a los periódicos. El objetivo principal de Facebook es conectar a las personas entre sí. De ello se desprende que sus pautas reflejarían más esta diversidad y estarían diseñadas para la seguridad de esa comunidad, en lugar de algún tipo de mantra de publicación de noticias o ideología vacía.

Nos gustaría que Facebook fuera más transparente sobre las formas en que modera a millones de personas y fragmentos de contenido todos los días. Arrojar más luz sobre estos temas ayuda a señalar los problemas y le da a Facebook la oportunidad de mejorar la seguridad de su comunidad. Y nos gustaría que Facebook invirtiera mucho más de sus ingresos en garantizar que tenga suficiente personal para mantener segura su plataforma. Para todos los usuarios.

Para mayor información

Notas al pie:

- Ah, y tenga en cuenta que si tiene 100,000 seguidores más en Facebook, a sus ojos eso lo convierte en una "figura pública", y no está sujeto a la privacidad u otras protecciones de la gente común. [↩]