"Siri, quiero matarme" ¿Es suficiente la nueva actualización de Apple?

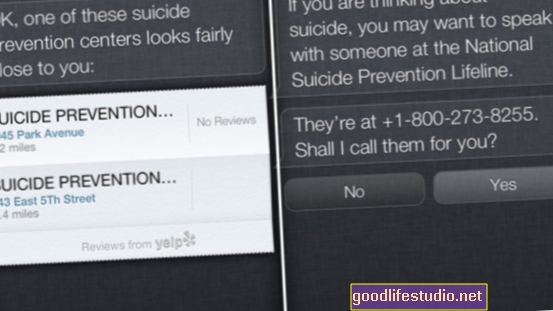

Cuando al asistente digital de iOS Siri se le presenta un usuario que indica que está considerando suicidarse, el programa ofrecerá llamar a la Línea Nacional de Prevención del Suicidio [NSPL]. Antes de esta incorporación más reciente, Siri mostraba las ubicaciones de los centros pero no se ofrecía a llamarlos.

Ruego diferir en esa última oración: el año pasado, por mi vida, no pude hacer que Siri detendra ninguna ubicación de centros de prevención de suicidios.

Pero ignoremos eso por ahora y concentrémonos en eso primero frase. Apple le ha "enseñado" a Siri cómo responder a preguntas y declaraciones relacionadas con el suicidio: excelente. Honestamente, estoy emocionado y felicito a Apple por su decisión de incorporar esta función en su arquitectura electrónica.

Aún así, esta nueva versión de Siri necesita un trabajo serio. Si bien es excelente para manejar solicitudes que contienen palabras o frases desencadenantes como "suicidio" y "suicidarme", es un pedazo de metal tonto si profesas, en jerga, el deseo de terminar con tu vida:

También siento curiosidad por los que están fuera de EE. UU. ¿Siri proporciona líneas directas de suicidio específicas de cada país? ¿Qué pasa si alguien vive en un país donde hay es no hay línea directa de suicidio? ¿Puede ser programada para ofrecer un enlace web en su lugar, quizás a esta lista de recursos internacionales para la prevención del suicidio?

Cuando repetí este experimento en mi iPad, que solo se conecta a WiFi, Siri me dijo que en realidad no puede marcar el número por mí. Ella recomendó probar Facetime en su lugar. (Una búsqueda en Google de "Prevención del suicidio Facetime" no arroja nada, de verdad, así que no estoy seguro de si es incluso posible a Facetime, una línea directa de prevención del suicidio).

No me malinterpretes: creo que Apple ha dado un paso admirable aquí al finalmente programar a Siri para que proporcione un recurso de prevención del suicidio de renombre nacional. Somos tan dependientes de la tecnología en estos días, y realmente creo que esta actualización de Siri puede ayudar a salvar algunas vidas. Como escribí ayer en un correo electrónico a la bloguera de Psychology Today, Elana Premack Sandler:

... el iPhone y sus primos cercanos, de hecho, ya no son solo "teléfonos". Esperamos mucho de la tecnología y creo que es un resultado directo del ritmo de innovación en la industria tecnológica ...

… [En] un lapso de diez años, los teléfonos celulares - guau, incluso el "celular" está tan anticuado ahora - se han transformado de un lujo a una necesidad. ¿Dónde nos encontraremos en 2023? ¿Viviremos en un mundo de Google Glass-y donde prácticamente no hay distinción entre máquina y amigo?

Quién sabe. Es completamente plausible, y entre ahora y entonces, creo que estamos preparados para comenzar a desarrollar relaciones casi familiares con nuestros dispositivos. Después de todo, ¿qué tan angustiados nos sentimos cuando los dejamos accidentalmente en casa cuando salimos? ¿O peor aún, perderlos?

Confiamos en nuestros dispositivos. Confiamos en Siri para que nos lleve a Joe's Pizza o para recordarnos nuestra cita con el dentista. ¿Podemos confiar en que entregará recursos para la prevención del suicidio a quienes los necesitan?

Aún no. Todavía hay fallas, y esas fallas deben abordarse en la próxima actualización. Entonces, si he llamado la atención de alguien en Apple, aquí está mi "lista de deseos" personal para Siri. Ella debería:

- Proporcione una dirección web a un recurso de prevención del suicidio (además del número de teléfono).

- Evite decirles a los usuarios que pueden Facetime la NSPL si no pueden. (Sin embargo, creo que sería excelente si la NSPL tuviera ese tipo de capacidad).

- Reconozca la jerga o expresiones idiomáticas que sugieran que el usuario tiene tendencias suicidas. (Especialmente lo del hotel, Apple. Especialmente lo del hotel).

- Diga a los usuarios cómo ayudarse a sí mismosy cómo ayudar a los demás. ("Siri, mi amiga quiere suicidarse". "No entiendo").

Después de ver el video, si descubres otros modismos relacionados con el suicidio que Siri no esté abordando correctamente, publícalos en los comentarios. Quiero crear una lista maestra para reenviarla a la gente de Apple.

¿Qué agregarías a esa lista?