Los científicos entienden las palabras de un paciente paralítico a través de señales cerebrales

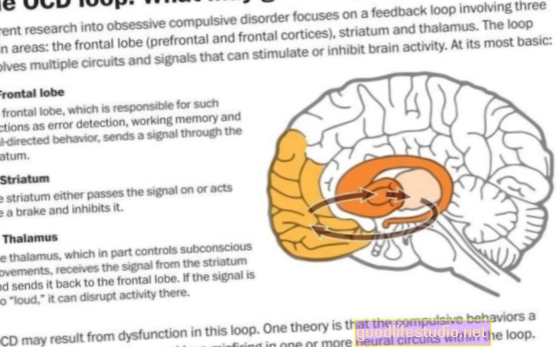

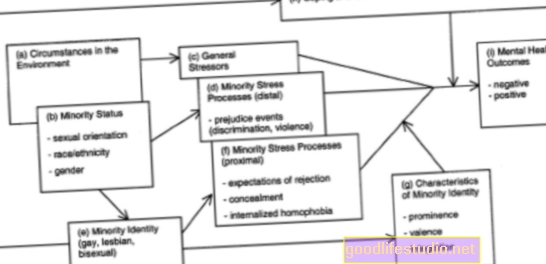

Los científicos utilizaron un nuevo tipo de microelectrodo no penetrante que se coloca en la parte superior del cerebro sin tocarlo. Estos electrodos se conocen como microECoG porque son una adaptación más pequeña de los electrodos grandes utilizados en electrocorticografía, o ECoG, que se desarrollaron hace varias décadas.

“Hemos sido capaces de decodificar palabras habladas usando sólo señales del cerebro con un dispositivo que promete un uso a largo plazo en pacientes paralizados que ahora no pueden hablar”, dijo Bradley Greger, profesor asistente de bioingeniería.

Un voluntario que ya había tenido una craneotomía, una extirpación parcial temporal del cráneo, en un esfuerzo por ayudar a sus ataques epilépticos graves, se ofreció como voluntario para la investigación. Los científicos colocaron rejillas de microelectrodos en la parte superior de los centros del habla de su cerebro: en la corteza motora facial, que controla los movimientos de los músculos involucrados en el habla, y también en el área de Wernicke, que está asociada con la comprensión y comprensión del lenguaje.

Dado que los microelectrodos en realidad no perforan la materia cerebral, se considera seguro colocarlos en las áreas del habla del cerebro. Con estos microelectrodos en su lugar, los científicos pudieron detectar y registrar las señales eléctricas cerebrales generadas por los pocos miles de neuronas o células nerviosas.

Después de que el voluntario leyera repetidamente cada una de las 10 palabras que podrían ser útiles para una persona paralizada (sí, no, calor, frío, hambre, sed, hola, adiós, más y menos), los investigadores intentaron averiguar qué señales cerebrales representaban cada una de las 10 palabras analizando los cambios en la fuerza de las diferentes frecuencias que entran con cada señal nerviosa.

Cuando se compararon dos señales cerebrales, como las generadas cuando el hombre dijo las palabras "sí" y "no", los científicos pudieron distinguir entre cada palabra entre el 76 y el 90 por ciento de las veces.

Cuando los científicos usaron solo los cinco microelectrodos en cada cuadrícula de 16 electrodos que eran más precisos para decodificar las señales cerebrales de la corteza motora facial, su precisión para distinguir entre palabras aumentó a casi el 90 por ciento.

Sin embargo, cuando los científicos observaron los 10 patrones de señales cerebrales a la vez, pudieron etiquetar correctamente cada palabra solo entre el 28 y el 48 por ciento de las veces. Esto fue mejor que el azar (10 por ciento), pero aún no se considera lo suficientemente fuerte.

"No significa que el problema esté completamente resuelto y todos podamos irnos a casa", dice Greger. "Significa que funciona, y ahora debemos perfeccionarlo para que las personas con síndrome de 'encerrado' realmente puedan comunicarse".

“El siguiente paso obvio, y esto es lo que estamos haciendo ahora mismo, es hacerlo con redes de microelectrodos más grandes. Podemos agrandar la cuadrícula, tener más electrodos y obtener una enorme cantidad de datos del cerebro, lo que probablemente significa más palabras y mayor precisión ”, dice Greger.

“Esta es una prueba de concepto. Hemos demostrado que estas señales pueden indicarle lo que la persona está diciendo muy por encima del azar. Pero debemos ser capaces de hacer más palabras con más precisión antes de que sea algo que el paciente pueda encontrar realmente útil ”, agrega.

Debido a que el método necesita muchas más mejoras e implica colocar electrodos en el cerebro, Greger espera que pasen algunos años antes de que haya ensayos clínicos en personas paralizadas que no pueden hablar.

Sin embargo, existe la esperanza de que la investigación continua en esta área eventualmente produzca un dispositivo inalámbrico que pueda convertir los pensamientos de una persona en palabras habladas por computadora, dice Greger. En este momento, la única forma en que las personas que están "encerradas" pueden comunicarse es mediante el movimiento, como parpadear o mover levemente una mano o eligiendo cuidadosamente letras o palabras de una lista.

Los colegas de la Universidad de Utah que realizaron el estudio con Greger incluyeron a los ingenieros eléctricos Spencer Kellis, un estudiante de doctorado, y Richard Brown, decano de la Facultad de Ingeniería; y Paul House, profesor asistente de neurocirugía. Otro coautor fue Kai Miller, neurocientífico de la Universidad de Washington en Seattle.

La investigación fue financiada por los Institutos Nacionales de Salud, la Agencia de Proyectos de Investigación Avanzada de Defensa, la Fundación de Investigación de la Universidad de Utah y la Fundación Nacional de Ciencias.

losRevista de ingeniería neuronalLa edición de septiembre publicará el estudio de Greger que muestra la viabilidad de traducir las señales cerebrales en palabras habladas por computadora.

Fuente: Universidad de Utah