Escuchando el "efecto cóctel" en el cerebro

Algunas personas pueden concentrarse en un solo hablante a pesar de que el entorno circundante oscurece la voz de una persona. El entorno puede ser un aula, un bar o un evento deportivo; la capacidad no es única y los psicólogos la han descrito como el "efecto cóctel".

Un nuevo esfuerzo de investigación dirigido por un neurocirujano de la Universidad de California en San Francisco y un becario postdoctoral se centró en descubrir cómo funciona la audición selectiva en el cerebro.

Edward Chang, M.D., y Nima Mesgarani, Ph.D., trabajaron con tres pacientes que se sometían a una cirugía cerebral por epilepsia grave.

Parte de esta cirugía implica identificar las partes del cerebro responsables de las convulsiones incapacitantes. Este ejercicio implica un mapeo de la actividad del cerebro durante una semana, con una hoja delgada de hasta 256 electrodos colocados debajo del cráneo en la superficie externa o corteza del cerebro. Los electrodos registran la actividad en el lóbulo temporal, hogar de la corteza auditiva.

Chang dijo que la capacidad de registrar grabaciones intracraneales de forma segura brinda oportunidades únicas para avanzar en el conocimiento fundamental de cómo funciona el cerebro.

"La combinación de grabaciones cerebrales de alta resolución y potentes algoritmos de decodificación abre una ventana a la experiencia subjetiva de la mente que nunca antes habíamos visto", dijo Chang.

En los experimentos, los pacientes escucharon dos muestras de voz que se les reproducían simultáneamente en las que diferentes hablantes pronunciaban diferentes frases. Se les pidió que identificaran las palabras que escucharon pronunciadas por uno de los dos hablantes.

Luego, los autores aplicaron nuevos métodos de decodificación para "reconstruir" lo que los sujetos escucharon al analizar sus patrones de actividad cerebral.

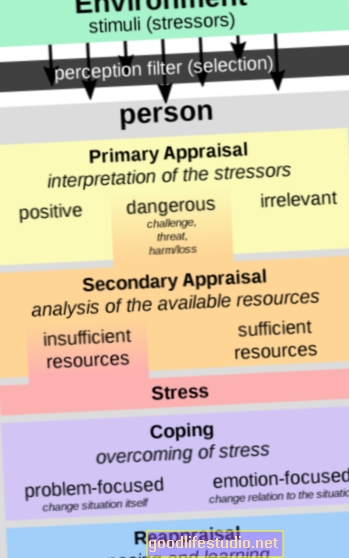

Sorprendentemente, los autores encontraron que las respuestas neuronales en la corteza auditiva solo reflejaban las del hablante objetivo. Descubrieron que su algoritmo de decodificación podía predecir qué hablante e incluso qué palabras específicas estaba escuchando el sujeto en función de esos patrones neuronales. En otras palabras, podían saber cuándo la atención del oyente se desviaba hacia otro hablante.

"El algoritmo funcionó tan bien que pudimos predecir no solo las respuestas correctas, sino también cuando prestaron atención a la palabra incorrecta", dijo Chang.

Los nuevos hallazgos muestran que la representación del habla en la corteza no solo refleja todo el entorno acústico externo, sino lo que realmente queremos o necesitamos escuchar.

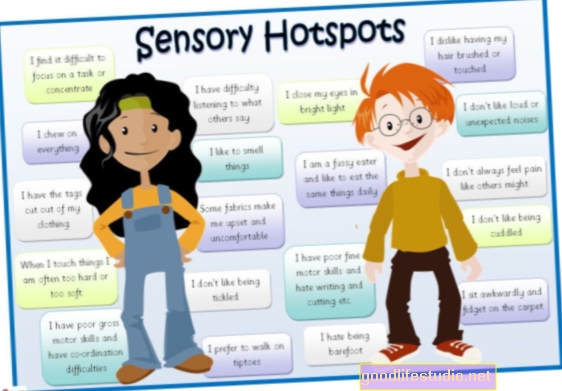

Representan un gran avance en la comprensión de cómo el cerebro humano procesa el lenguaje, con implicaciones inmediatas para el estudio del deterioro durante el envejecimiento, el trastorno por déficit de atención, el autismo y los trastornos del aprendizaje del lenguaje.

Además, Chang dice que algún día podremos utilizar esta tecnología para dispositivos neuroprotésicos para decodificar las intenciones y pensamientos de pacientes paralizados que no pueden comunicarse.

Comprender cómo están conectados nuestros cerebros para favorecer algunas señales auditivas sobre otras puede fomentar nuevos enfoques para automatizar y mejorar la forma en que las interfaces electrónicas activadas por voz filtran los sonidos para detectar correctamente los comandos verbales.

El método por el cual el cerebro puede concentrarse de manera tan eficaz en una sola voz es un área de gran interés para las empresas que desarrollan dispositivos electrónicos con interfaces de voz activa.

Si bien las tecnologías de reconocimiento de voz que permiten interfaces como Siri de Apple han avanzado mucho en los últimos años, no son tan sofisticadas como el sistema de voz humano. Por ejemplo, una persona promedio puede entrar en una habitación ruidosa y tener una conversación privada con relativa facilidad, como si todas las demás voces de la habitación estuvieran silenciadas.

El reconocimiento de voz, dijo Mesgarani, un ingeniero con experiencia en la investigación del reconocimiento automático de voz, es "algo en lo que los humanos somos notablemente buenos, pero resulta que la emulación de esta habilidad humana mediante una máquina es extremadamente difícil".

El artículo de investigación aparece en la revista Naturaleza.

Fuente: Universidad de California, San Francisco (UCSF)